以KV緩存為中心的高效長(zhǎng)文本方法的優(yōu)化和實(shí)踐——2025AICon全球人工智能開發(fā)與應(yīng)用大會(huì)上海站

在人工智能應(yīng)用軟件開發(fā)領(lǐng)域,處理長(zhǎng)文本數(shù)據(jù)一直是一個(gè)重要的挑戰(zhàn)。隨著模型規(guī)模的不斷擴(kuò)大和應(yīng)用場(chǎng)景的復(fù)雜化,如何高效地處理長(zhǎng)序列輸入成為了業(yè)界關(guān)注的焦點(diǎn)。KV(Key-Value)緩存技術(shù)作為一種優(yōu)化手段,在長(zhǎng)文本處理中展現(xiàn)出顯著優(yōu)勢(shì)。

KV緩存技術(shù)通過存儲(chǔ)中間計(jì)算結(jié)果,避免了在推理過程中重復(fù)計(jì)算,從而大幅提升了模型的推理效率。在長(zhǎng)文本場(chǎng)景下,這種優(yōu)化尤為重要。傳統(tǒng)的自回歸模型在處理長(zhǎng)序列時(shí),每次生成新token都需要重新計(jì)算整個(gè)序列的注意力權(quán)重,計(jì)算復(fù)雜度隨序列長(zhǎng)度呈平方級(jí)增長(zhǎng)。而采用KV緩存后,模型只需計(jì)算新token的注意力權(quán)重,并與緩存的KV值結(jié)合,將計(jì)算復(fù)雜度降低到線性級(jí)別。

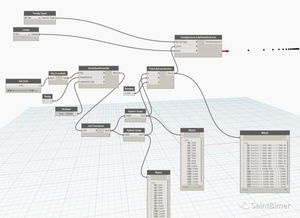

在實(shí)際應(yīng)用中,我們針對(duì)不同的業(yè)務(wù)場(chǎng)景進(jìn)行了多方面的優(yōu)化實(shí)踐:

- 動(dòng)態(tài)緩存管理:根據(jù)文本長(zhǎng)度和硬件資源動(dòng)態(tài)調(diào)整緩存大小,在保證性能的同時(shí)最大限度地節(jié)省內(nèi)存使用。通過智能的緩存淘汰策略,優(yōu)先保留對(duì)后續(xù)推理最重要的KV對(duì)。

- 分層緩存機(jī)制:針對(duì)不同層次的注意力頭設(shè)計(jì)差異化的緩存策略。研究發(fā)現(xiàn),底層注意力頭通常關(guān)注局部特征,而高層注意力頭更關(guān)注全局語義,因此采用不同的緩存粒度可以進(jìn)一步提升效率。

- 量化壓縮技術(shù):對(duì)KV緩存進(jìn)行低精度量化和壓縮,在保持模型性能基本不變的前提下,顯著減少內(nèi)存占用。實(shí)驗(yàn)表明,8位量化可以將緩存內(nèi)存占用減少75%,而性能損失控制在可接受范圍內(nèi)。

- 多模態(tài)擴(kuò)展:將KV緩存技術(shù)擴(kuò)展到多模態(tài)場(chǎng)景,在文本-圖像、文本-視頻等跨模態(tài)任務(wù)中實(shí)現(xiàn)高效推理。通過設(shè)計(jì)統(tǒng)一的緩存架構(gòu),支持不同類型數(shù)據(jù)的協(xié)同處理。

在2025AICon大會(huì)上海站的實(shí)踐中,我們展示了基于KV緩存優(yōu)化的長(zhǎng)文本處理系統(tǒng)在實(shí)際業(yè)務(wù)中的表現(xiàn)。在智能客服、文檔摘要、代碼生成等場(chǎng)景中,系統(tǒng)處理長(zhǎng)文本的效率提升了3-5倍,同時(shí)保持了高質(zhì)量的生成效果。

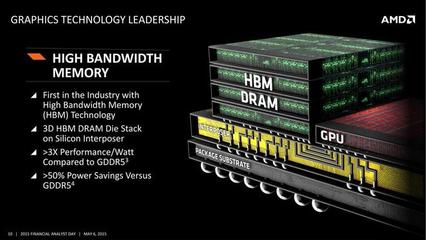

隨著模型繼續(xù)向更大規(guī)模、更長(zhǎng)上下文發(fā)展,KV緩存技術(shù)的優(yōu)化將變得更加關(guān)鍵。我們正在探索基于硬件特性的專用緩存架構(gòu)、自適應(yīng)緩存粒度調(diào)整等前沿方向,致力于為人工智能應(yīng)用軟件開發(fā)提供更高效、更可靠的底層技術(shù)支持。

如若轉(zhuǎn)載,請(qǐng)注明出處:http://www.loewak.cn/product/22.html

更新時(shí)間:2026-01-09 13:55:37